基于持续学习的多模态情绪感知系统

作者:骆炳君 邵璟之 软件学院

指导老师:赵曦滨 软件学院

关键词:情绪感知、持续学习、多模态

摘要

情绪是人类认知、思考与行为过程中所产生的复杂心理和生理状态。情绪感知技术在人机交互、工业控制、医疗教育等领域取得了广泛的应用,是分析用户行为、评估心理状态、监控病情发展等任务的重要工具,具有极高的研究和应用价值。实际应用中的情绪具有表达通道多样化和种类精细化的特点:情绪的表达通道丰富多样,例如面部表情、动作等视觉信号以及心电(ECG)、脑电(EEG)等生理信号;情绪分类日趋精细化,越来越多的复杂情绪类型开始被公众所创造、关注和使用。针对上述特点所带来的挑战,本作品充分利用视觉信息与生理信号等多模态的数据,探索多模态数据在情绪感知中的复杂关联,深度融合多模态学习和持续学习的理论方法,提出了更加准确可靠的精细化情绪感知方法,在此基础上设计搭建了面向真实场景的司乘人员情绪监测系统。

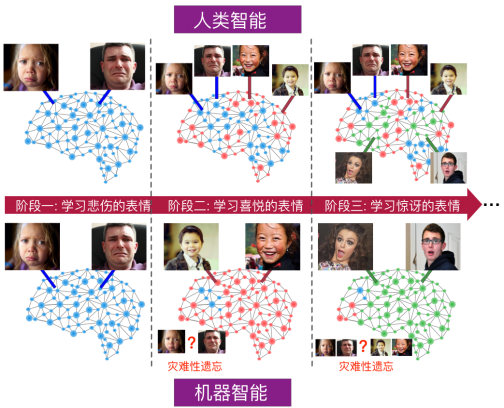

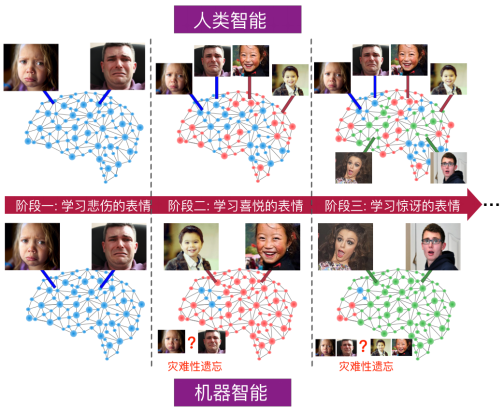

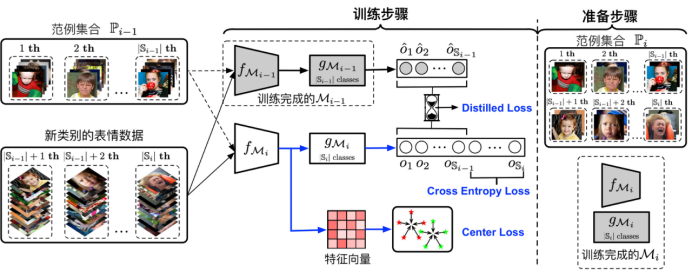

精细化情绪的动态建模方法

传统的持续学习研究多局限于图像分类任务,在情绪感知领域还处于一片空白。本作品首次将持续学习的理论方法应用于情绪感知任务中,针对情绪多样性和个体差异性的特点提出了新的训练损失函数,构建了类型可动态增加的情绪感知模型。与传统的固定分类情绪感知模型相比,我们的模型不仅能灵活地适应情绪类型的动态变化,还能在保持较高准确率的前提下,大大减少模型增量训练过程中的时间和空间开销。相关成果已发表于ACM MM 2020会议,正在申请专利1项。

图1 人类智能与机器智能在不断学习新类别情绪时的对比

图2 动态情绪感知模型框架

多模态生理信号的情绪预测方法

为了能够利用多模态生理信号对个体情绪状态进行监测,形成心理素质的个性化客观量化评估,本作品提出了用超图对样本之间的复杂关联进行统一建模,通过多模态之间的信息融合,联合学习端到端的特征表示方法,充分利用不同模态的信息,对比个体间的生理属性,最终实现对于情绪状态的精确识别。相关成果已发表于ICIP 2019会议。

图3 多模态情绪预测模型框架

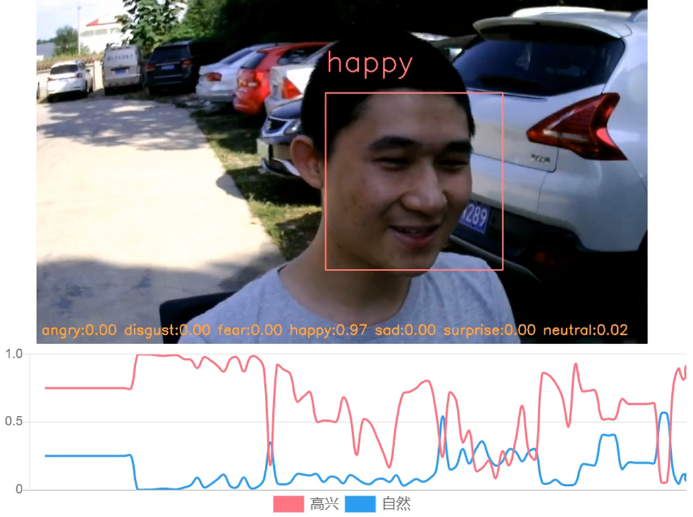

司乘人员情绪检测原型系统

本作品在前述两项成果的基础上,充分利用已有研究的知识和技术积累,基于人脸表情数据实现了对公共交通司乘人员的情绪监测与分析。未来将融合多模态学习和持续学习方法,充分利用多模态的视觉信息和生理信号数据,进一步提高分析的准确性和可靠性。相关工作已搭建原型系统,预期与交通运输企业合作使产品落地应用。

图4 情绪监测原型系统演示